Table of Contents

Warum LLM-unabhaengige Memory-Layer die Zukunft der KI-Architektur sind

In der schnelllebigen Welt der Large Language Models aendert sich die Technologielandschaft staendig. Neue Modelle mit verbesserten Kontextfenstern, besseren Tool-Calling-Faehigkeiten und optimierter Inferenz-Performance erscheinen regelmaessig. Fuer Unternehmen stellt sich dabei eine zentrale Frage: Wie bauen wir KI-Systeme, die nicht bei jedem Modellwechsel neu aufgesetzt werden muessen?

Die Antwort liegt in einer klaren Architekturentscheidung: LLM-unabhaengige Memory-Layer. Waehrend Sprachmodelle austauschbar sind und primaer als Reasoning-Engine dienen, liegt der dauerhafte Unternehmenswert in den Daten, Tools und Retrieval-Mechanismen. Diese Erkenntnis ist nicht nur fuer grosse Konzerne relevant, sondern fuer praktisch jedes Unternehmen, das ernsthaft mit KI arbeitet.

Bei Orbitype behandeln wir LLMs, Datenbanken, Storage und Compute als gleichwertige Bausteine eines offenen Oekosystems. Alle Komponenten sind ueber standardisierte APIs verbunden, ohne proprietaere Formate, die zu Vendor Lock-in fuehren wuerden. Diese Architekturentscheidung ermoeglicht es uns, flexibel auf neue Entwicklungen zu reagieren und gleichzeitig die Investitionen in Daten und Tooling zu schuetzen.

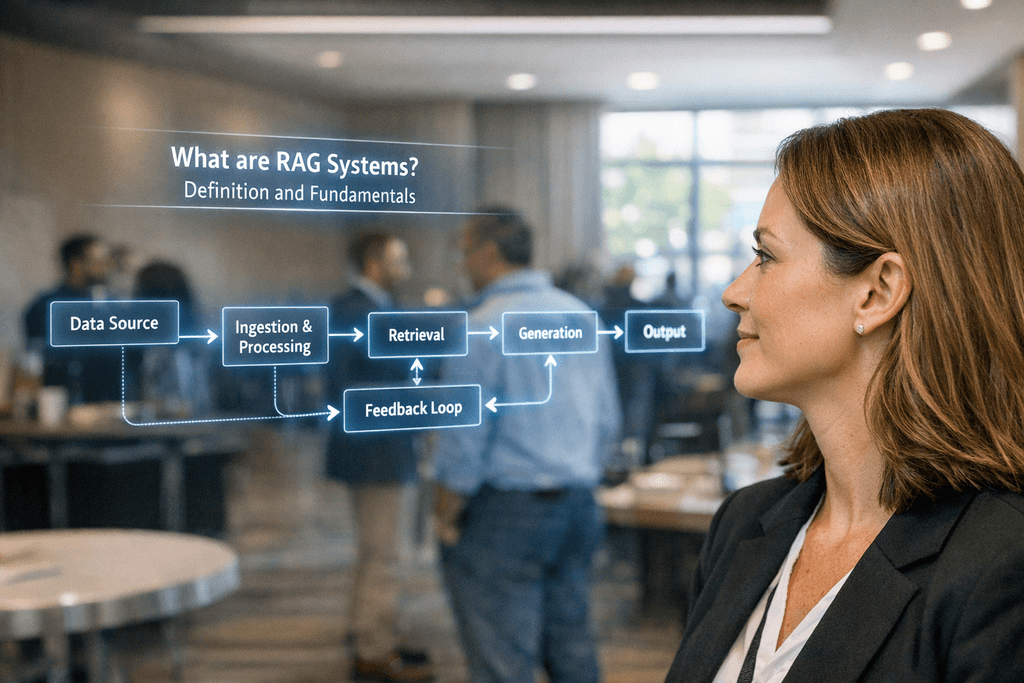

RAG als Tool in deterministischen Workflows: Praezision statt Kontextflut

Retrieval-Augmented Generation (RAG) hat sich als Schluesselkomponente moderner KI-Systeme etabliert. Doch die Implementierung entscheidet ueber Erfolg oder Misserfolg. Viele Unternehmen begehen den Fehler, RAG als eigenstaendige Loesung zu betrachten, anstatt es als praezises Werkzeug in groessere, deterministische Workflows zu integrieren.

In der Praxis bedeutet das: RAG-Systeme sollten nicht isoliert operieren, sondern als Tool innerhalb strukturierter Prozesse. Wir setzen auf ReAct-style Agents, die in der Lage sind, zu entscheiden, wann und wie RAG-Retrieval eingesetzt wird. Dieser Ansatz fuehrt zu token-effizientem, hochpraezisem Retrieval nach dem Prinzip "weniger Kontext, mehr Wirkung".

Die technische Umsetzung basiert auf mehreren Saeulen:

- Strukturierte Workflows: Deterministische Prozesse definieren klare Entscheidungspunkte, an denen RAG-Retrieval ausgeloest wird

- Token-Effizienz: Statt massenhaft Kontext in Prompts zu laden, werden nur die relevantesten Informationen abgerufen

- Granulare Berechtigungen: Auf Source-, Tag- und Memory-Ebene wird gesteuert, welche Informationen ein Agent sehen darf und muss

- Praezises Retrieval: Hybrid-Search kombiniert semantische Vektorsuche mit Metadaten-Filterung fuer optimale Ergebnisse

Diese Architektur ermoeglicht es, RAG-Systeme skalierbar und kosteneffizient einzusetzen, ohne die Qualitaet der Ergebnisse zu kompromittieren.

Postgres als stabile Basis: pgvector und die Zukunft von Graph-RAG

Die Wahl der Datenbank-Technologie ist eine der wichtigsten Architekturentscheidungen beim Aufbau von KI-Systemen. Waehrend viele Anbieter auf spezialisierte Vektor-Datenbanken setzen, haben wir uns bewusst fuer PostgreSQL als Fundament entschieden. Diese Entscheidung basiert auf mehreren strategischen Ueberlegungen.

PostgreSQL bietet unuebertroffene Stabilitaet und ein ausgereiftes Oekosystem. Mit Jahrzehnten der Entwicklung und einer weltweiten Community ist Postgres eine der zuverlaessigsten Datenbanken ueberhaupt. Die Erweiterung mit pgvector ermoeglicht native Vektorsuche direkt in der Datenbank, ohne zusaetzliche Infrastruktur.

Die technischen Vorteile von pgvector sind erheblich:

- Native Integration: Vektoren werden als nativer Datentyp behandelt, keine externe Synchronisation noetig

- SQL-Kompatibilitaet: Komplexe Queries kombinieren relationale und Vektor-Operationen in einer Abfrage

- Performance: Millisekunden-Antwortzeiten auch bei Millionen von Vektoren durch optimierte Indexstrukturen (HNSW, IVFFlat)

- Transaktionssicherheit: ACID-Garantien auch fuer Vektor-Operationen

- Kosteneffizienz: Keine zusaetzlichen Lizenzkosten oder spezialisierte Infrastruktur

Fuer hochvernetzte Wissensstrukturen evaluieren wir zusaetzlich Graph-RAG-Ansaetze. Diese erweitern klassisches RAG um die Faehigkeit, komplexe Beziehungen zwischen Entitaeten zu modellieren und zu durchsuchen. Besonders bei Unternehmens-Knowledge-Bases mit vielen Querverweisen und Abhaengigkeiten bietet Graph-RAG erhebliche Vorteile gegenueber rein vektorbasierter Suche.

Fine-Tuning vs. RAG: Wann eigene Modelle Sinn machen

Die Frage "Fine-Tuning oder RAG?" wird in der KI-Community intensiv diskutiert. Unsere Position basiert auf praktischer Erfahrung: Fine-Tuning sollte primaer fuer Tonalitaet und Verhalten eingesetzt werden, nicht als Wissensspeicher.

Die Gruende dafuer sind pragmatisch:

- Schnelle Alterung: In Modelle eingebranntes Wissen veraltet schnell und ist schwer zu aktualisieren

- Schwierige Kontrolle: Es ist unklar, welches Wissen das Modell tatsaechlich gelernt hat und wie zuverlaessig es abgerufen wird

- Hohe Kosten: Jeder Modellwechsel erfordert erneutes Fine-Tuning mit erheblichem Aufwand

- Mangelnde Transparenz: Keine Nachvollziehbarkeit, woher Informationen stammen (keine Source Attribution)

RAG-Systeme loesen diese Probleme elegant: Wissen bleibt in strukturierten Datenbanken, ist jederzeit aktualisierbar, und jede Antwort kann auf ihre Quellen zurueckgefuehrt werden.

Wann macht eigenes Training mit domainspezifischem Fine-Tuning dennoch Sinn? Nur wenn der Use Case so spezialisiert und differenziert ist, dass grosse Anbieter realistischerweise nicht dafuer optimieren koennen. Sobald Sie ausreichend hochwertige Domaenen-Daten gesammelt haben, koennen Custom Models unter spezifischen Umgebungs- oder Betriebsbedingungen General-Purpose-LLMs uebertreffen.

Ein weiterer Vorteil: Sie sind weniger dem "Latest Model Race" ausgesetzt, da Sie nach eigenem Zeitplan iterieren koennen. Vor Erreichen dieser Datenschwelle liefern jedoch starke General Models plus gutes Prompting, Tooling und Retrieval typischerweise bessere Ergebnisse bei deutlich geringeren Kosten und Komplexitaet.

Die gute Nachricht: Alles, was Sie in Tooling- und Memory-Layern aufbauen, laesst sich spaeter sauber auf Custom Models portieren. Es gibt also keine verschwendete Arbeit.

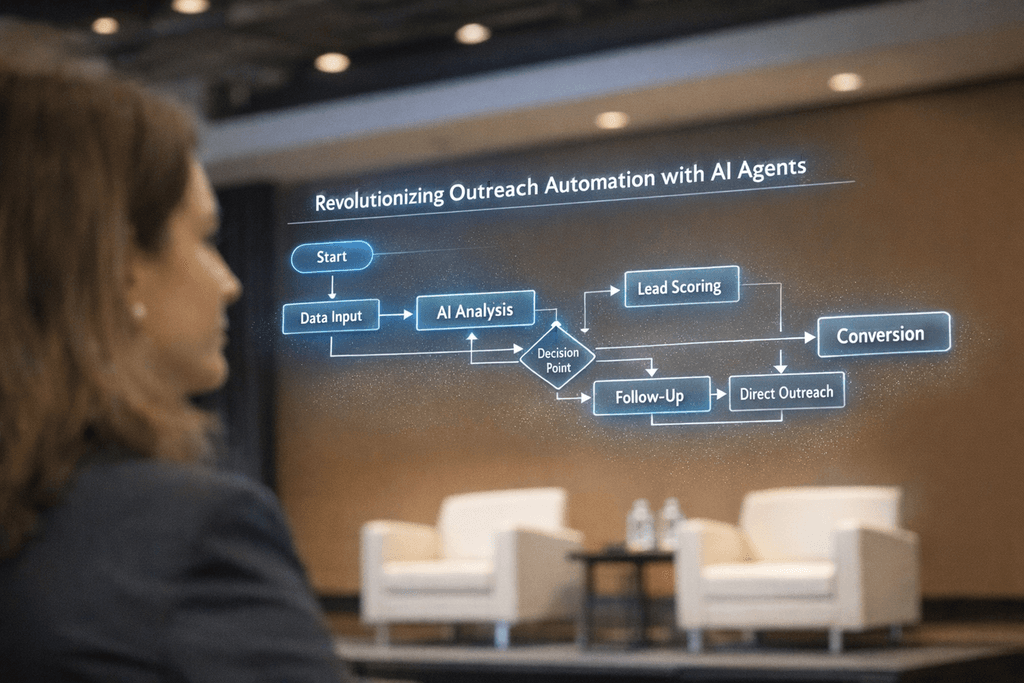

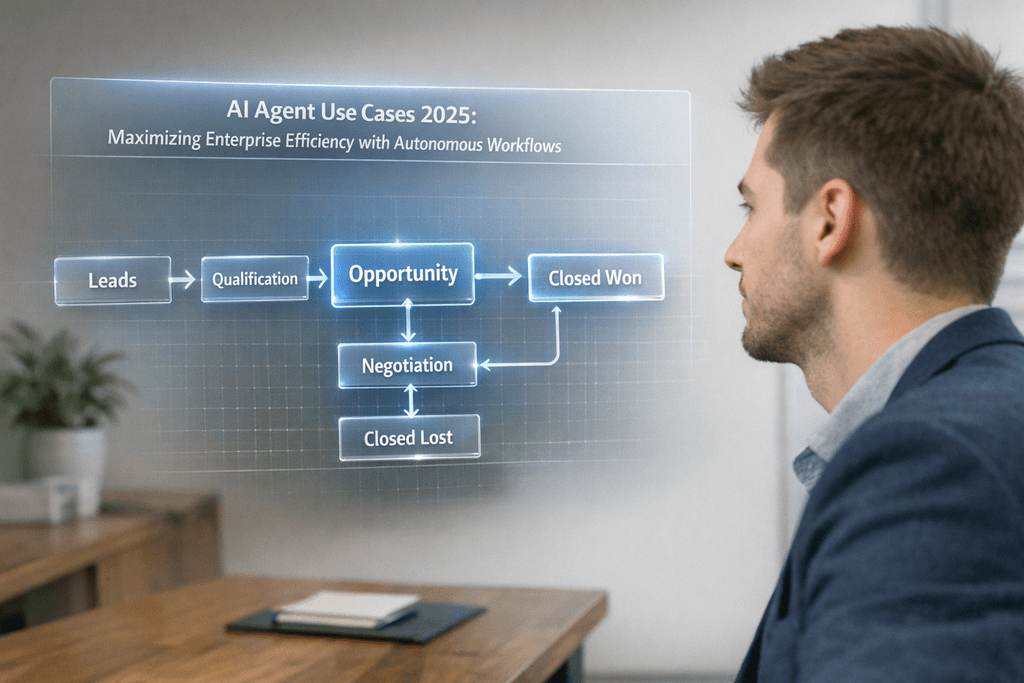

Multi-Agent-Architekturen: Zentrale Vector-Datenbank mit Berechtigungen

In vielen produktiven KI-Setups laeuft nicht ein einzelner Agent, sondern ein Oekosystem spezialisierter Agenten, die auf eine gemeinsame Wissensbasis zugreifen. Diese Architektur bietet erhebliche Vorteile gegenueber isolierten Systemen.

Eine zentrale Vector-Datenbank mit granularen Berechtigungen dient als gemeinsame Wissensschicht, verbunden mit mehreren Agenten unterschiedlicher Rollen. Wichtig: Oft laufen auch Workflows komplett ohne Agenten, wenn deterministische Prozesse ausreichen.

Die Agenten-Typologie in solchen Systemen:

- Execution-fokussierte Agenten: Query, Decide, Act - diese Agenten fuehren konkrete Aufgaben aus (z.B. E-Mail-Beantwortung, Datenextraktion, API-Aufrufe)

- RAG-Improvement-Agenten: Research, Condensation, Structuring, Quality Checks, Deduplication - diese Agenten verbessern kontinuierlich die Wissensbasis selbst

Das Berechtigungssystem ist dabei zentral: Jeder Agent sieht nur die Informationen, die er sehen darf und muss. Dies wird auf mehreren Ebenen durchgesetzt:

- Source-Level: Zugriff auf bestimmte Datenquellen (z.B. HR-Dokumente nur fuer HR-Agenten)

- Tag-Level: Filterung nach Metadaten und Kategorien

- Memory-Level: Zugriff auf spezifische Konversations- oder Session-Memories

Diese Architektur ermoeglicht es, komplexe AI-Agent-Workflows sicher und skalierbar zu betreiben, ohne dass sensible Informationen in falsche Haende geraten.

Der elegante Teil: Alles, was Sie in den Tooling- und Memory-Layern aufbauen, laesst sich spaeter sauber auf Custom Models portieren. Es gibt also keine verschwendete Arbeit, wenn Sie spaeter zu eigenen Modellen wechseln moechten.

Praktische Implementierung: Von der Theorie zur produktiven Loesung

Die Implementierung einer LLM-unabhaengigen Memory-Architektur mag komplex klingen, ist aber mit den richtigen Tools und Methoden gut umsetzbar. Hier zeigen wir einen praxiserprobten Ansatz.

Phase 1: Datenbank-Setup mit pgvector

Der erste Schritt ist die Einrichtung einer PostgreSQL-Datenbank mit pgvector-Extension. In Orbitype erfolgt dies mit einem Klick, alternativ kann eine bestehende Postgres-Instanz erweitert werden:

- Installation der pgvector-Extension

- Erstellung von Tabellen fuer Dokumente, Embeddings und Metadaten

- Einrichtung von HNSW- oder IVFFlat-Indizes fuer performante Vektorsuche

- Definition von Berechtigungsstrukturen auf Tabellen- und Row-Level

Phase 2: Embedding-Pipeline

Dokumente und Wissensquellen muessen in Vektoren umgewandelt werden. Best Practices:

- Chunking-Strategie: Dokumente in sinnvolle Abschnitte teilen (300-500 Tokens)

- Overlap: 10-20% Ueberlappung zwischen Chunks fuer Kontext-Erhalt

- Metadaten: Source, Timestamp, Tags, Permissions bei jedem Chunk speichern

- Embedding-Model: text-embedding-3-large oder domain-spezifische Alternativen

Phase 3: Retrieval-Layer

Der Retrieval-Layer kombiniert verschiedene Suchtechniken:

- Hybrid Search: Vektorsuche + Keyword-Matching + Metadaten-Filter

- Reranking: Zweistufiges Retrieval mit Reranking-Model fuer hoehere Praezision

- Permission-Filtering: Automatische Filterung basierend auf Agent-Rolle

Phase 4: Agent-Integration

Agenten werden als ReAct-style Loops implementiert, die RAG als Tool nutzen koennen. In modernen AI-Agent-Frameworks erfolgt dies ueber Tool-Calling-Interfaces, die dem LLM erlauben, selbst zu entscheiden, wann Retrieval benoetigt wird.

Diese Architektur ist produktionsreif, skalierbar und - das Wichtigste - unabhaengig vom verwendeten LLM. Ein Wechsel von GPT-4 zu Claude oder einem Open-Source-Modell erfordert nur minimale Anpassungen.

Performance-Optimierung und Skalierung von RAG-Systemen

Ein produktives RAG-System muss nicht nur funktional korrekt sein, sondern auch unter Last performant bleiben. Die Optimierung erfolgt auf mehreren Ebenen.

Index-Optimierung

Die Wahl des richtigen Vektorindex ist entscheidend fuer Performance:

- HNSW (Hierarchical Navigable Small World): Beste Wahl fuer die meisten Anwendungsfaelle, exzellente Balance zwischen Geschwindigkeit und Praezision

- IVFFlat: Geeignet fuer sehr grosse Datenmengen, etwas geringere Praezision, aber deutlich schneller bei Millionen von Vektoren

- Parameter-Tuning: ef_construction, ef_search und m-Parameter beeinflussen Trade-off zwischen Geschwindigkeit und Qualitaet

Caching-Strategien

Intelligentes Caching reduziert Latenz erheblich:

- Embedding-Cache: Haeufig gesuchte Queries werden vorberechnet

- Result-Cache: Identische Suchanfragen liefern gecachte Ergebnisse

- Semantic-Cache: Aehnliche Queries nutzen aehnliche Ergebnisse

Batch-Processing

Fuer grosse Datenmengen ist Batch-Processing essentiell:

- Parallele Embedding-Generierung mit Worker-Pools

- Bulk-Insert-Operationen fuer neue Dokumente

- Asynchrone Index-Updates ohne Downtime

Monitoring und Observability

Produktive Systeme benoetigen umfassendes Monitoring:

- Latenz-Metriken fuer Retrieval-Operationen

- Qualitaets-Metriken: Precision@k, Recall@k, MRR

- Ressourcen-Monitoring: CPU, Memory, Disk I/O

- Business-Metriken: Erfolgsrate von Agent-Tasks, User-Satisfaction

Mit diesen Optimierungen lassen sich RAG-Systeme auf Millionen von Dokumenten und tausende gleichzeitige Anfragen skalieren, ohne die Antwortqualitaet zu beeintraechtigen.

Sicherheit und Compliance in Multi-Tenant-RAG-Systemen

Sicherheit ist bei Unternehmens-KI-Systemen nicht optional. Besonders bei Multi-Tenant-Architekturen, wo mehrere Kunden oder Abteilungen dieselbe Infrastruktur nutzen, sind robuste Sicherheitsmechanismen essentiell.

Row-Level Security (RLS) in PostgreSQL

PostgreSQL bietet native Row-Level Security, die perfekt fuer RAG-Systeme geeignet ist:

- Policies definieren, welche Rows ein User oder Agent sehen darf

- Automatische Filterung auf Datenbankebene, keine Application-Logic noetig

- Performance-optimiert durch Index-Integration

Verschluesselung auf mehreren Ebenen

- At Rest: Datenbank-Verschluesselung fuer gespeicherte Daten

- In Transit: TLS/SSL fuer alle API-Kommunikation

- Application Level: Zusaetzliche Verschluesselung sensibler Felder

Audit Logging und Compliance

Fuer regulierte Branchen ist lueckenlose Nachvollziehbarkeit erforderlich:

- Logging aller Zugriffe auf sensible Daten

- Versionierung von Dokumenten und Aenderungshistorie

- Retention Policies fuer automatisches Loeschen nach Ablauf

- GDPR-konforme Datenverarbeitung mit Right-to-be-forgotten-Mechanismen

API-Security

- Token-basierte Authentifizierung (JWT, OAuth2)

- Rate Limiting pro User/Agent

- Input Validation und Sanitization

- CORS-Policies fuer Web-Zugriffe

Prompt Injection Prevention

RAG-Systeme sind potentiell anfaellig fuer Prompt Injection Attacks. Schutzmassnahmen:

- Strikte Trennung von System-Prompts und User-Input

- Input-Filtering und Blacklisting gefaehrlicher Patterns

- Output-Validation vor Rueckgabe an User

- Sandbox-Execution fuer Tool-Calling

Diese Sicherheitsmassnahmen sind in Orbitype nativ integriert und ermoeglichen sichere Multi-Tenant-Deployments ohne zusaetzlichen Implementierungsaufwand.

Fazit: Investition in dauerhafte Werte statt in austauschbare Modelle

Die KI-Landschaft entwickelt sich rasant weiter, aber eine Wahrheit bleibt konstant: Der dauerhafte Wert liegt nicht im Modell, sondern in Daten, Tools und Retrieval-Mechanismen. Unternehmen, die heute auf LLM-unabhaengige Architekturen setzen, schaffen eine zukunftssichere Basis fuer ihre KI-Strategie.

Die wichtigsten Erkenntnisse zusammengefasst:

- LLMs sind austauschbare Reasoning-Engines, der Wert liegt im Memory-Layer

- RAG als Tool in deterministischen Workflows bietet optimale Balance zwischen Flexibilitaet und Kontrolle

- PostgreSQL mit pgvector bietet eine stabile, skalierbare Basis ohne Vendor Lock-in

- Fine-Tuning macht nur fuer hochspezialisierte Use Cases Sinn, nicht als Wissensspeicher

- Multi-Agent-Architekturen mit granularen Berechtigungen ermoeglichen sichere, skalierbare Systeme

Bei Orbitype haben wir diese Prinzipien konsequent umgesetzt. Unsere Plattform behandelt alle Komponenten als gleichwertige, offene Bausteine, die ueber APIs verbunden sind. Dies ermoeglicht maximale Flexibilitaet ohne proprietaere Formate oder Lock-in.

Der Weg nach vorne ist klar: Investieren Sie in Ihre Dateninfrastruktur, bauen Sie robuste Retrieval-Mechanismen auf, und behandeln Sie LLMs als austauschbare Komponenten. Alles, was Sie in Tooling und Memory-Layern aufbauen, bleibt wertvoll - unabhaengig davon, welches Modell naechstes Jahr State-of-the-Art ist.

Die KI-Revolution findet nicht in den Modellen statt, sondern in der Art, wie wir Wissen strukturieren, speichern und zugaenglich machen. Unternehmen, die das verstehen, werden die Gewinner der naechsten Dekade sein.

Quellen und weiterfuehrende Ressourcen

Dieser Artikel basiert auf praktischen Erfahrungen und aktueller Forschung im Bereich KI-Architekturen. Folgende Ressourcen bieten weiterfuehrende Informationen:

Orbitype Ressourcen:

- What are RAG Systems? Definition and Fundamentals

- AI Agent Use Cases 2025: Maximizing Enterprise Efficiency

- AI Agent Revolution: Guide to Development & Best Practices

- Orbitype Platform

Technische Dokumentation:

- PostgreSQL pgvector Extension: Offizielle Dokumentation fuer Vektor-Operationen in PostgreSQL

- LangChain Framework: Tools fuer LLM-basierte Anwendungen und RAG-Systeme

- ReAct Pattern: Research Paper zu Reasoning and Acting in Language Models

Best Practices und Standards:

- OWASP AI Security Guidelines: Sicherheitsrichtlinien fuer KI-Systeme

- GDPR Compliance fuer AI: Datenschutzkonformitaet bei KI-Anwendungen

- Multi-Tenant Architecture Patterns: Architekturmuster fuer mandantenfaehige Systeme

Fuer Fragen zur Implementierung oder spezifischen Use Cases stehen wir gerne zur Verfuegung.